AlphaGo(阿爾法狗)戰(zhàn)勝了柯潔,人工智能贏了,贏家仍然是人類!

之前介紹過深度強化學習DRL,其中一個最最經典的應用就是谷歌DeepMind團隊研發(fā)的圍棋程序AlphaGo(阿爾法狗)。AlphaGo的勝利將深度強化學習推上新的熱點和高度,成為AI人工智能歷史上一個新的里程碑。

有必要跟大家一起探討一下AlphaGo(阿爾法狗),了解一下AlphaGo背后神奇的AI力量。

圍棋的程序設計:

圍棋是一個完美的、有趣的數學問題。

圍棋棋盤是19x19路,所以一共是361個交叉點,每個交叉點有三種狀態(tài),可以用1表示黑子,-1表示白字,0表示無子,考慮到每個位置還可能有落子的時間、這個位置的氣等其他信息,可以用一個361 * n維的向量來表示一個棋盤的狀態(tài)。則把一個棋盤狀態(tài)向量記為s。

當狀態(tài)s下,暫時不考慮無法落子的地方,可供下一步落子的空間也是361個。把下一步的落子的行動也用361維的向量來表示記為a。

于是,設計一個圍棋人工智能的程序,就轉變?yōu)椋喝我饨o定一個s狀態(tài),尋找最好的應對策略a,讓程序按照這個策略走,最后獲得棋盤上最大的地盤。

谷歌DeepMind的圍棋程序AlphaGo(阿爾法狗)就是基于這樣思想設計的。

AlphaGo概述:

AlphaGo(阿爾法狗)創(chuàng)新性地將深度強化學習DRL和蒙特卡羅樹搜索MCTS相結合, 通過價值網絡(value network)評估局面以減小搜索深度, 利用策略網絡(policy network)降低搜索寬度, 使搜索效率得到大幅提升, 勝率估算也更加精確。

MCTS必要性:

AlphaGo(阿爾法狗)系統(tǒng)中除了深度強化學習DRL外,為什么還需要蒙特卡羅樹搜索?

圍棋棋面總共有19 * 19 = 361個落子位置。假如計算機有足夠的計算能力,理論上來說,可以窮舉黑白雙方所有可能的落子位置,找到最優(yōu)或次優(yōu)落子策略。如果窮舉黑白雙方所有可能的落子位置,各種組合的總數,大約是 250^150 數量級,即圍棋的計算復雜度約為250的150次方。假如采用傳統(tǒng)的暴力搜索方式(遍歷搜索方式),用當今世界最強大云計算系統(tǒng),算幾十年也算不完。按照現(xiàn)有的計算能力是遠遠無法解決圍棋問題的。早期計算機圍棋軟件通過專家系統(tǒng)和模糊匹配縮小搜索空間, 減輕計算強度, 但受限于計算資源和硬件能力, 實際效果并不理想。

但是到了2006年,蒙特卡羅樹搜索的應用標志著計算機圍棋進入了嶄新階段。

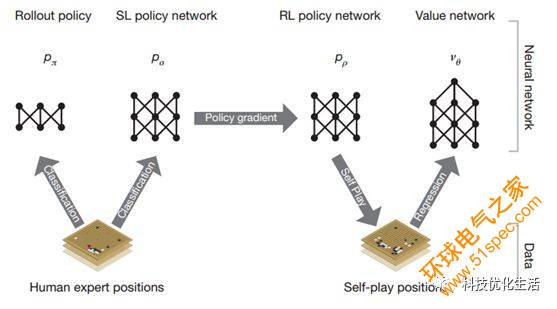

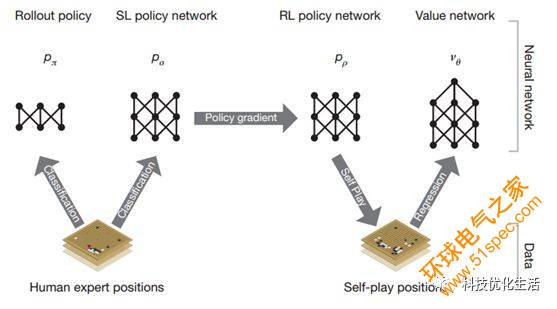

AlphaGo網絡結構:

網絡結構如下圖所示:

AlphaGo系統(tǒng)組成:

AlphaGo(阿爾法狗)系統(tǒng)主要由幾個部分組成:

1.策略網絡(Policy Network):給定當前圍棋局面,預測/采樣下一步的走棋。

2.快速走子(Fast rollout):目標和策略網絡一樣,只不過圍棋有時間限制,需要在規(guī)定時間內適當犧牲走棋質量情況下,快速落子,速度要比策略網絡要快1000倍。

3.價值網絡(Value Network):給定當前圍棋局面,估計是白勝還是黑勝。

4.蒙特卡羅樹搜索(Monte Carlo Tree Search):不窮舉所有組合,找到最優(yōu)或次優(yōu)位置。

把以上這四個部分結合起來,形成一個完整的AlphaGo(阿爾法狗)系統(tǒng)。

蒙特卡洛樹搜索 (MCTS) 是一個大框架,許多博弈AI都會采用這個框架。強化學習(RL)是學習方法,用來提升AI的實力。深度學習(DL)采用了深度神經網絡 (DNN),它是工具,用來擬合圍棋局面評估函數和策略函數的。蒙特卡洛樹搜索 (MCTS) 和強化學習RL讓具有自學能力、并行的圍棋博弈算法成為可能。深度學習(DL)讓量化地評估圍棋局面成為了可能。

小結:

可以說 AlphaGo 最大優(yōu)勢就是它應用了通用算法,而不是僅局限于圍棋領域的算法。AlphaGo勝利證明了像圍棋這樣復雜的問題,都可以通過先進的AI人工智能技術來解決。